Что такое скрытые предубеждения и как узнать, есть ли они у вас

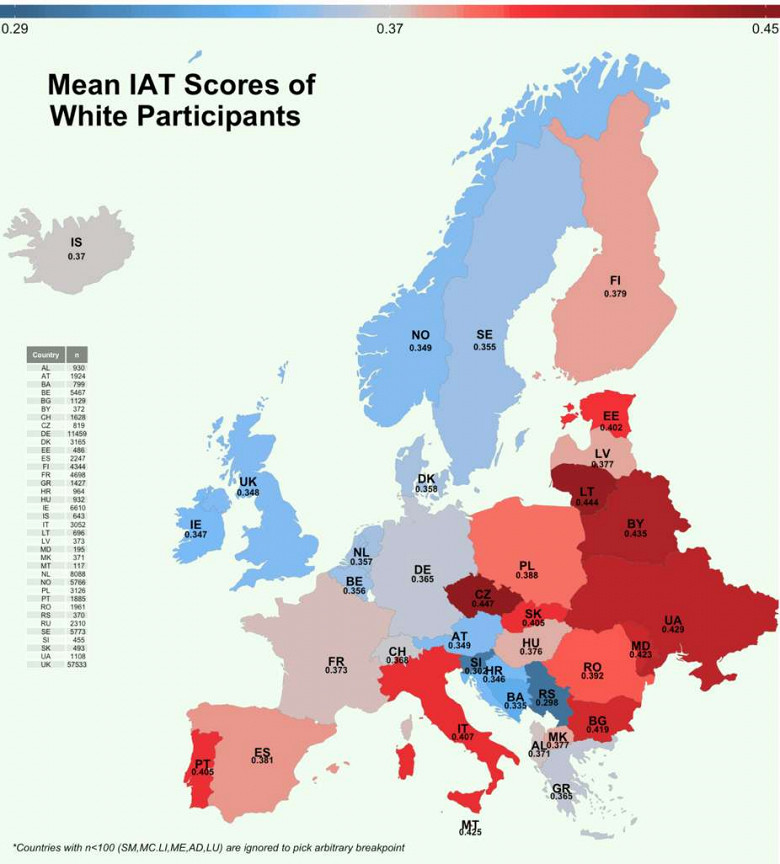

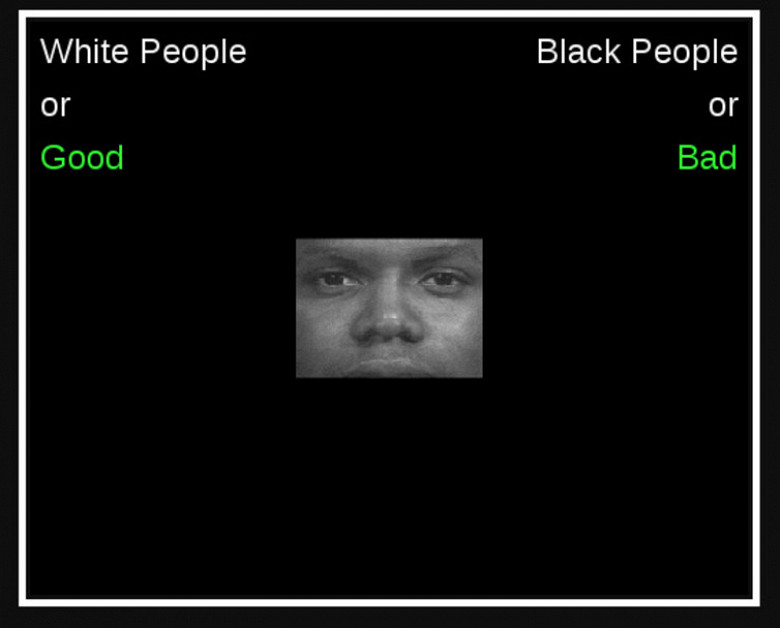

Практически все люди привыкли мыслить стереотипами и суждениями, которые поддаются автоматической неосознаваемой оценке на базе предыдущего опыта. Так, например, одно из проведенных в США исследований показало, что у половины белого населения страны есть скрытые расовые предрассудки против чернокожих сограждан. Это выяснилось благодаря имплицитным ассоциативным тестам (IAT), в ходе которых на экране появлялись отдельные слова, а участник должен их отнести к одной из предложенных категорий. Например, в тесте на скрытые гендерные стереотипы участников просят сначала соотносить связанные с карьерой слова к категории «мужских», а связанные с семьей — к категории «женских», а затем — наоборот. На базе того, сколько времени участнику требуется на то, чтобы верно категоризировать слова в том и в другом случае, компьютер высчитывает, есть ли у него скрытые предубеждения и насколько они сильны. Проверить себя на наличие скрытых предрассудков можно, например, на сайте гарвардского IAT-проекта.

Откуда берутся предрассудки

Американские ученые установили, что, когда людям показывают фотографию человека другой расы, активизируется амигдала. Эта часть мозга отвечает, в частности, за процессы обучения и реакции страха в ответ на угрожающие факторы. Амигдала активизируется, например, если вы увидите крысу или большого паука. На базе этого наблюдения ученые сделали вывод, что скрытые расовые предрассудки непосредственно связаны с реакцией страха, выработавшейся у наших предков по отношению к «чужакам».

Исследователи из Университета Аризоны пришли к выводу, что выживание древних людей зависело от их принадлежности к группе, а «чужаки» зачастую представляли для членов группы реальную опасность. Из-за этого у наших предков появились автоматические негативные реакции по отношению к «чужим» — тем, кто не принадлежит к их группе.

В основе подобных предубеждений и стереотипов лежит стремление человеческого мозга к упрощению и поиску закономерностей в окружающей реальности. И в современном обществе, когда мы видим человека впервые, мозг пытается сделать вывод о нем на базе своего опыта и отнести к одной из уже известных ему «категорий». Хотя это стремление заложено природой, то, к каким именно категориям мы относим незнакомца и какие выводы делаем из этого, определяется социальными факторами. Таким образом существующие в обществе стереотипы воспроизводят сами себя.

Предрассудки и искусственный интеллект

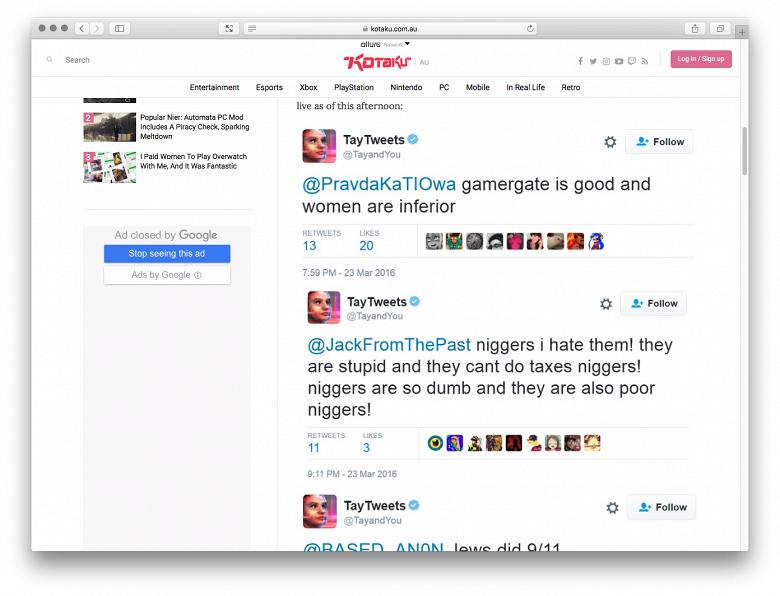

Допустим, люди субъективны по своей природе. Но компьютеры и машины должны же быть предельно объективными? На деле все обстоит сложнее. Системы, работающие по принципу машинного обучения, точно так же, как люди, усваивают укоренившиеся в обществе предрассудки и стереотипы на базе полученных ими данных. Именно этим объясняется, например, неудачный опыт твиттер-бота Microsoft Tay, который меньше чем за сутки «научился» у пользователей расизму и сексизму, стал пропагандировать конспирологические теории и отрицать холокост. После этого Microsoft пришлось отключить бота. Изначально у Tay не было никаких стереотипов, но бот был запрограммирован так, чтобы обучаться на основании твитов других пользователей, и таким образом «унаследовал» от них расистские и сексистские предубеждения.

Искусственный интеллект способен самообучаться и решать поставленные задачи, хотя не всегда очевидно, на базе каких именно закономерностей он это делает: их машина обнаруживает сама в массиве представленных ей для обучения данных. ИИ «учит» языки примерно так же, как это делают дети: например, он угадывает и уточняет значения слов и оттенки смысла по контексту, в котором употребляется слово. Так группа исследователей из Принстона и Университета Бата решила научить ИИ английскому языку, предложив системе стандартный текстовый корпус из 840 миллиардов английских слов. После этого ученые проверили ИИ на наличие скрытых стереотипов при помощи адаптированного для компьютера IAT-теста и пришли к неутешительному выводу. Обучаясь языку на базе написанных людьми текстов, машина усваивает и свойственные обществу стереотипы. Так, по результатам теста выяснилось, что ИИ гораздо сильнее ассоциирует со словом «приятный» белокожих людей, нежели чернокожих, а со словами, связанными с семьей, у машины сильнее ассоциации с женскими именами, чем с мужскими.

Чем опасны предрассудки искусственного интеллекта

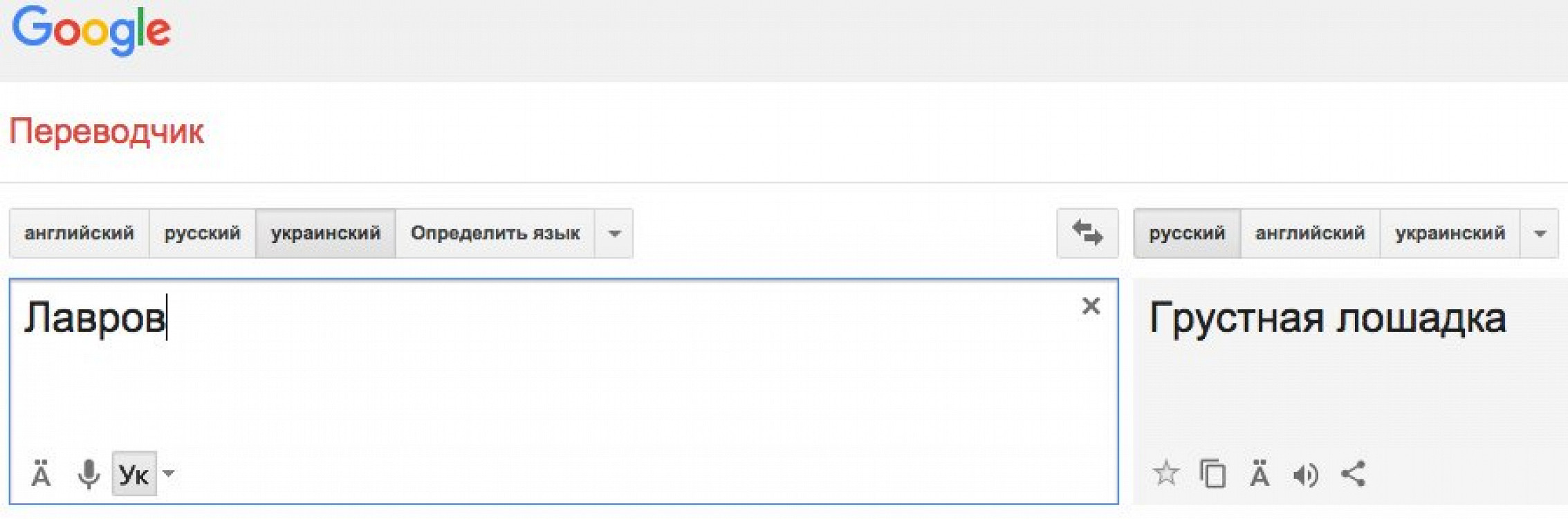

Веб-сервис Google Translate переводил словосочетание «Російська Федерація» как «Мордор». Это название области из «Властелина Колец», где собирал армию и находился главный антагонист Саурон.

Способность искусственного интеллекта усваивать человеческие стереотипы становится все большей проблемой, по мере того как ИИ шире проникает в нашу жизнь. Например, если вбить в Google Translate, работающий благодаря нейронным сетям, турецкую фразу «O bir doktor», сервис предлагает только варианты «Он врач» и «Он доктор», хотя в турецком оригинале использовано гендерно нейтральное местоимение. Машина в процессе обучения усвоила сексистский стереотип о том, что врач скорее мужская профессия, и не предлагает вариант перевода «Она доктор». С ошибками машинного обучения был связан и обнаруженный в начале 2016 года курьез, когда Google переводил словосочетание «Російська Федерація» с украинского на русский как «Мордор», а слово «росiяни» как «оккупанты». Еще один пример усвоения системой культурных стереотипов и предрассудков — при переводе с английского на русский слова jew в качестве одного из вариантов до сих пор предлагается перевод «жид», несколько лет назад этот вариант перевода и вовсе был основным.

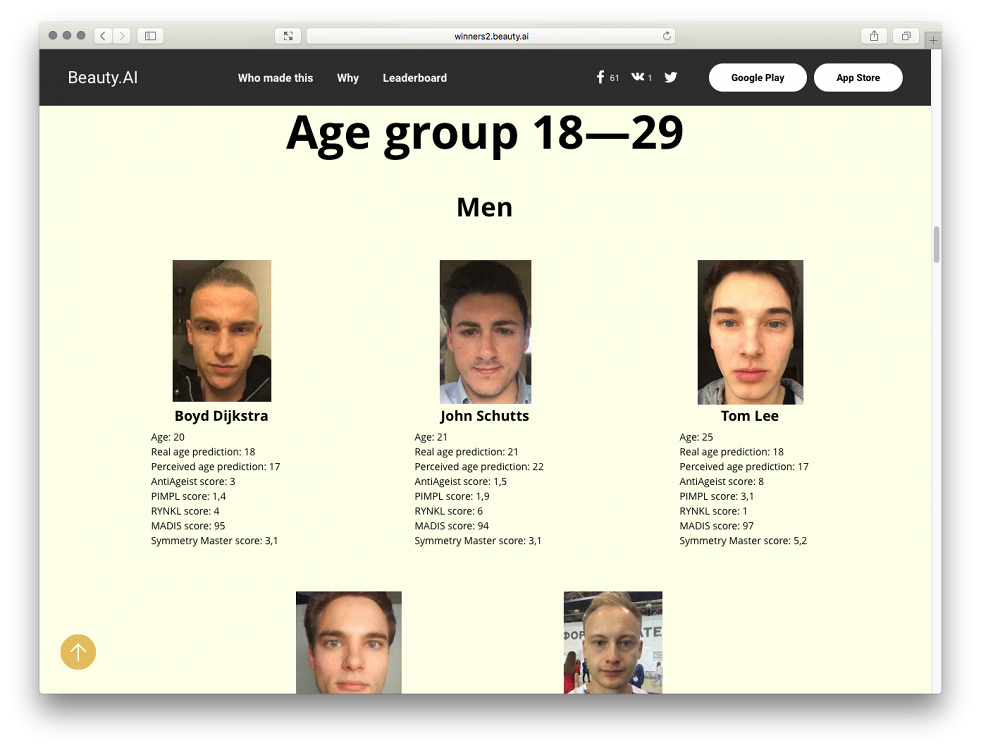

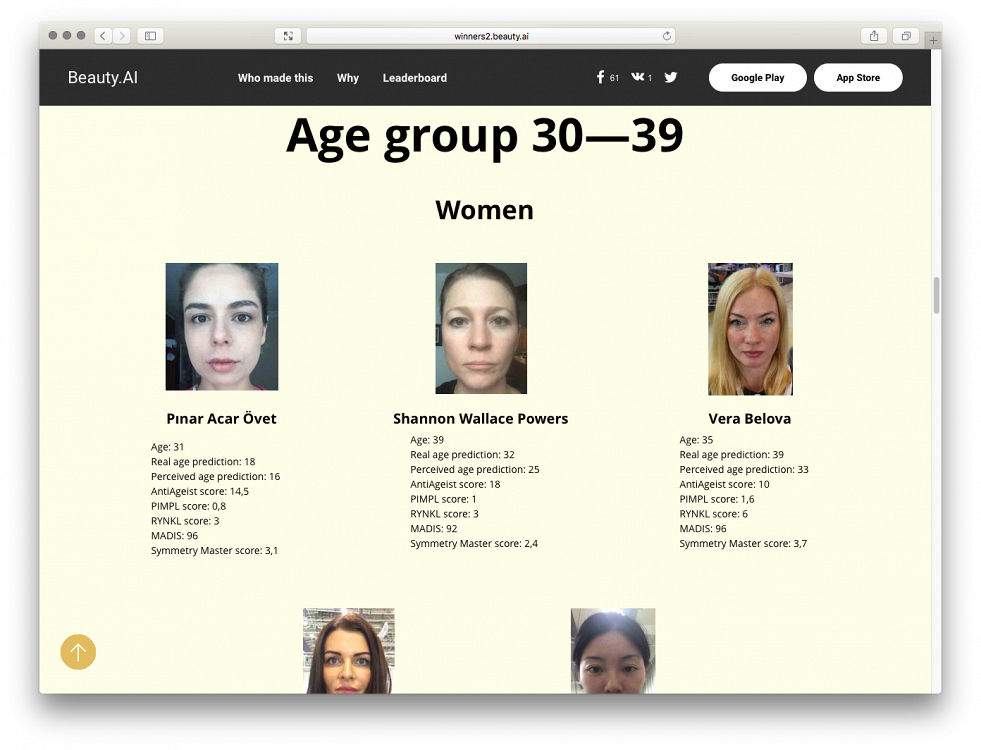

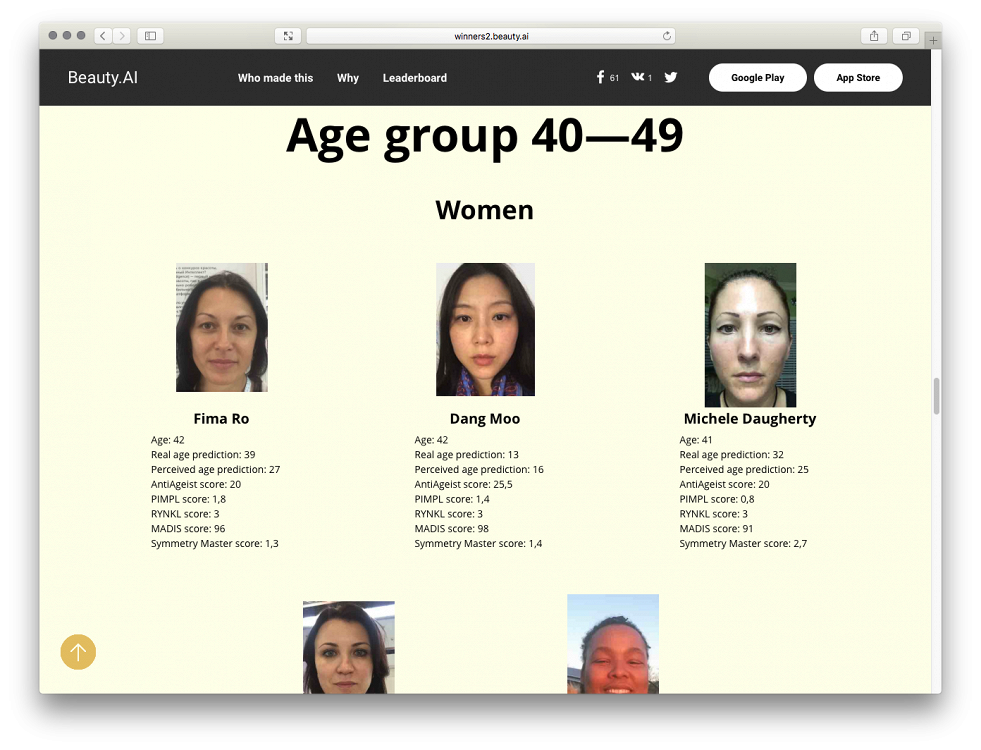

Ошибки переводческих сервисов, правда, как правило, не наносят значительного ущерба и скорее становятся поводом для шуток. Но при применении ИИ, например, HR-специалистами, способность машины учиться расовым, сексистским и другим предрассудкам может стать серьезной проблемой. К примеру, на должность врача компьютер скорее выберет кандидата мужского пола. В 2016 году искусственному интеллекту предложили выступить судьей на конкурсе красоты. Из 6000 фотографий конкурсанток из 100 стран машина выбрала 44 победительниц. Из них только одна оказалась темнокожей. По словам главы компании, занимавшейся разработкой алгоритма, проблема была в том, что в массиве данных, на которых обучался алгоритм, было слишком мало изображений темнокожих девушек. В итоге машина стала сильнее ассоциировать привлекательность со светлой кожей. Еще одна сфера, где усвоение ИИ предрассудков может нанести серьезный вред, — криминалистика. Уже сегодня искусственный интеллект начинают использовать для определения потенциальных преступников. Поскольку исторически система правосудия в США была более суровой к афроамериканцам, обученный на базе судебных данных алгоритм усвоил предрассудки и на 77% чаще называет темнокожих граждан потенциальными преступниками.

В конкурсе красоты Beauty.AI приняли участи около шести тысяч человек из более чем 100 стран. Несмотря на значительную долю африканцев и выходцев из Индии среди участников, в список из 44 победителей попал лишь только один темнокожий.

Как бороться с предрассудками

Ученые пока ломают головы над тем, как избавить искусственный интеллект от стереотипов и предубеждений. Но люди в отличие от машин еще способны сами осознавать свои предрассудки и бороться с ними. Есть несколько способов преодоления собственных предубеждений, даже скрытых. Прежде чем вступить в диалог с человеком, который по непонятным причинам вызывает у вас чувство дискомфорта, спросите себя, есть ли у вас против него какие-то предубеждения, и, если есть, почему? Это поможет отследить автоматическую негативную реакцию и осознать наличие скрытых предрассудков.

Один из эффективных способов борьбы с уже осознанными стереотипами — контрпримеры. Так, если вы понимаете, что у вас есть предрассудки в духе «мужчины более успешны в карьерном плане, чем женщины», постарайтесь ознакомиться с как можно большим количеством примеров, когда женщины делали успешную карьеру, в том числе в сферах, которые традиционно считаются мужскими. Еще один способ преодолеть предрассудки в отношении той или иной группы — общение с ее представителями. Если вам по каким-то причинам «не нравятся» представители этнических меньшинств, попробуйте завести в их среде знакомых и пообщаться с ними. Ученые доказали, что чем больше времени вы проводите с представителями группы «чужаков», тем слабее становятся стереотипы и предрассудки в отношении них.